Aggregated Residual Transformations for Deep Neural Networks (IEEE 2017)

Authors: Saining Xie, Ross Girshick, PiotrDollar, Zhuowen Tu, Kaiming He

-본 논문에서는 동일한 block을 반복적으로 구성하여 더 적은 파라미터를 통해 성능을 향상시키는 ResNeXt을 제안한다. ResNext는 multi-branch ResNet의 형태를 가지며 기존 residual block의 activation의 순서를 변경하고 convolution filter의 수를 변화시켰다. 또한 cardinality라는 개념을 소개한다. Cardinality는 같은 형태의 블록의 개수를 의미한다.

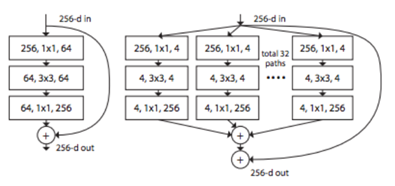

- 그림 1의 좌측이 ResNet이며 우측이 ResNeXt이다. 그림에서 처럼 residual block이 여러 개 인 것을 확인할 수 있다.

- 그림 2와 같이 3가지 ResNeXt 모델을 제안했다. ResNeXt의 residual block은 모든 block이 각 path마다 동일한 구조를 가지고 dimension이 모두 동일하기 때문에 사용하기 편리하다는 장점 또한 가진다.

댓글