Deep Pyramid Residual Networks. (CVPR 2017)

Authors: Dongyoon Han, Jiwhan Kim, Junmo Kim.

- 본 논문에서는 ResNet이 downsampling을 할 때 급격하게 변하는 feature map dimension에 초점을 두었다. ResNet의 경우 pooling layer에서 feature map size를 절반으로 줄이고 feature map channel를 2배 늘리지만, 본 논문에서 제안한 pyramidnet은 모든 layer에서 channel의 수가 변하도록, 점차적으로 네트워크의 width에 변화를 주었다.

- 좌측 그림이 ResNet이며, 우측 그림이 PyramidNet이다. 파란색 선이 downsampling이 일어나는 layer이다. 그림에서 처럼 좌측 ResNet의 downsampling시점에 성능이 급격하게 저하되는 것을 확인할 수 있다. 대조적으로 우측 pyramidnet은 모든 layer에서 성능저하가 동일하다.

- 기존의 네트워크는 downsampling layer를 제외하고 다른 모든 layer에서 convolution filter수가 동일했다면, PyramidNet에서는 모든 layer에서 filter수를 증가시켜 점차적으로 width를 늘리며 pyramid형태를 보인다.

- 그림 2의 가운데와 우측 그림과 같이 PyramidNet에서 layer의 width를 넓히는 방식은 2가지가 있다. 첫 번째는 가운데 그림과 같이 multiplicative 방식으로 지수배로 늘린다. 두 번째는 우측 그림으로 additive 방식으로 전체 layer에서 얼마나 width를 늘릴지 a를 정하고, 이전 width에 비해 a/N만큼 늘린다. N은 residual block의 개수이다.

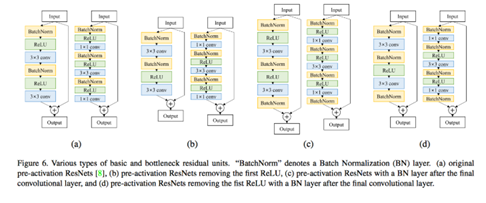

- 또한 본 논문에서는 Residual block안에 ReLU가 많으면 성능저하를 만들며, 그림 3의 (b), (d)와 같이 첫 번째 ReLU를 제거했다. 또한 이렇게 첫 ReLU를 제거하면 두 conv layer 사이에 non-linearity가 사라져서 representation power가 약해질수 있으므로 bathnormalization layer를 하나 더 추가했다. 이는 그림 3의 (d)를 통해 확인할 수 있다.

댓글